【已解决】使用workerman/rabbitmq写消费者,捕获到异常时,无法正常消费

问题描述

我希望的消费者业务流程时:

1)先从队列拿一条信息出来,先处理(ack)掉,无论业务逻辑成不成功

2)信息放到处理业务程序去处理。

要问的问题

如果业务程序中途出现异常,或者程序中途kill掉,发现队列中这条信息还在(或者ack不成功?)

如果进程正常跑没有异常或kill队列的信息是能正常消费的。

应该怎么改才能满足我的业务流程???????????

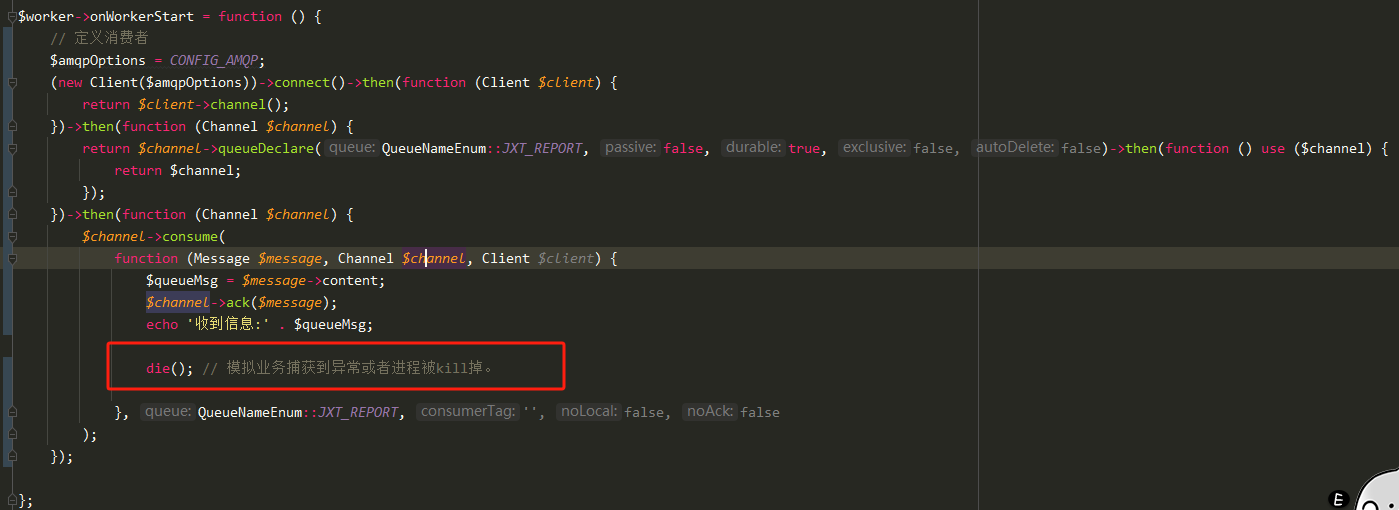

贴一下代码希望大佬指点指点

备注:说说为啥要先处理信息

我的思路是,无论这条信息对应的业务是否成功,消息都要处理,防止队列数据一直卡着。如果业务处理不成功,我会重新向队尾发送一条延时队列,重新处理。

3个回答

相关连接

年代过于久远,无法发表回答

赞助商

热门问答

PHP聊天系统源码-即时通讯聊天源码 - 泡泡IM

DeepSeek 本地部署教程(极其简单)

webman限流器发布

webman 数据库请求api 数据库读取5万条数据 出现502

有没有不分离的后台框架?

Webman AI + DeepSeek本地训练,打造私有知识库

线上API偶现There is already an active transaction异常

生产环境 Linux 使用 webman 无法操作 Redis 数据库

webman里能使用yar 提供服务吗

recv() failed (104: Connection reset by peer)

Bunny\Channel::consume 这个方法 有个noack 参数 默认为 false 改为true 看看

试过了,设置true的话,只要中途进程断了,队列里面所有信息都会清空了

不懂问下。你这个die()不会导致workerman退出吗?

旁边不是注释"模拟捕获异常或进程被kill"么

模拟异常

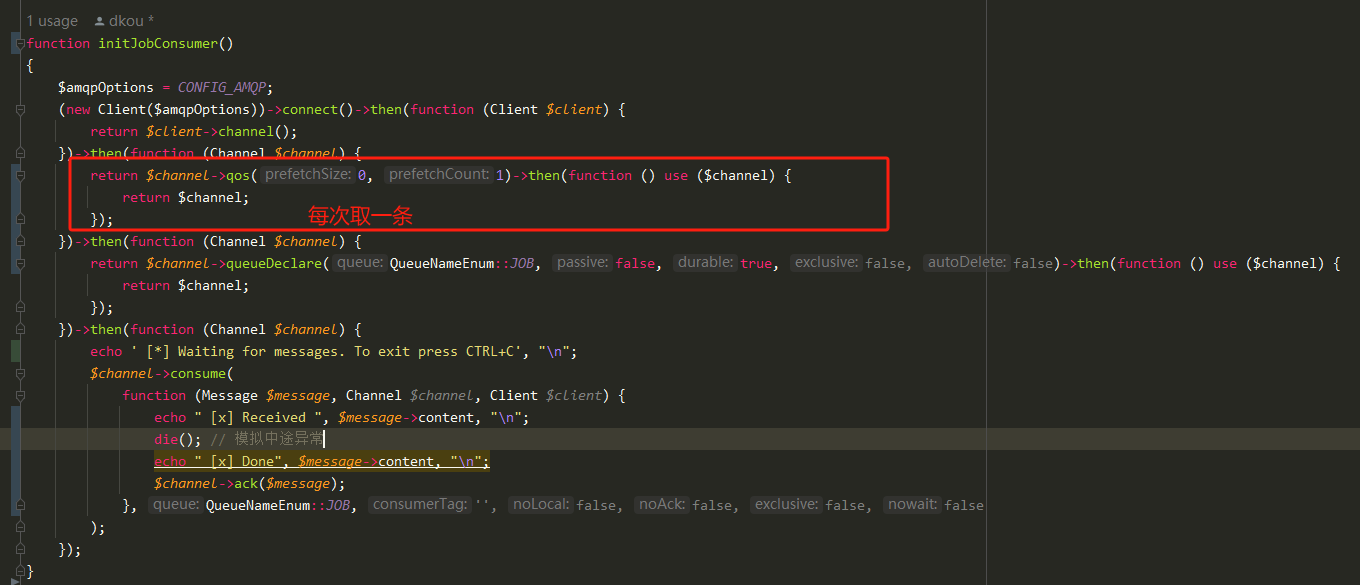

问题已自行解决

问题的关键:

通过自己调试发现,上述写法是流程是,先把队列信息批量取出来,处理,然后再一次性ack的,即假设队列有10条信息,会看到10条信息状态会先变成Unacked,等10条信息对也业务逻辑完,这10条信息才会消失。

因此,如果我在处理第3条时die()了,其实前2条队列信息是还没收到ack的,所以队列信息还在。

而我的要求,是要逐条信息处理,每条信息处理完就ack的,因此,应该要设置每次批量获取信息的数量,设置为1。以下是代码

题外话

经指点,我这种“无论这条信息对应的业务是否成功,消息都要处理,防止队列数据一直卡着。如果业务处理不成功,我会重新向队尾发送一条延时队列,重新处理。”处理方式在rabbitmq其实没必要的,因为本来就有ack机制,unacked的队列,会自己回到reday,不会被删除。因为以前使用redis做队列留下的思维。